人工智能风口正盛,一封呼吁暂停大型AI研究的公开信在硅谷科技圈流传开来,一石激起千层浪。

在众多大佬的光环下,这封信引起轩然大波,部分认为这就是是“酸葡萄心理”,AI竞赛中落后的玩家在为自己争取6个月的时间。

不过,也有人认为担忧有一定的合理性,AI发展太快,监管和审查方面没有跟上步伐。

有些人质疑强大的人工智能是否会实现, 也有些人坚信创建超级智能对人类必定是有益的。这两种情形皆有可能,但我们更意识到人工智能系统具有有意或无意造成巨大危害的潜力。我们相信今日的研究意在防患于未然,使得未来人们受益于AI的同时,规避潜在风险隐患。

01

人工智能的安全性

在短期内,保持人工智能对社会的影响的目标激发了许多领域的研究,从经济学和法律到验证、有效性、安全性和控制等技术主题。

如果笔记本电脑崩溃或被黑客入侵,它可能只是一个小麻烦,但如果人工智能系统控制汽车、飞机、心脏起搏器、自动交易系统或电网,它能做或者想做的事情就变得非常重要了。

从长远来看,一个重要的问题是,如果对强大人工智能的追求成功,并且人工智能系统在所有认知任务上都比人类更好,会发生什么。

正如I.J. Good在1965年指出的那样,设计更智能的人工智能系统本身就是一项认知任务。这样的系统可能会经历递归的自我改进,引发智能爆炸,将人类智力远远抛在后面。通过发明革命性的新技术,这种超级智能可能会帮助我们消除战争、疾病和贫困,因此创造强大的人工智能可能是人类历史上最大的事件。

不过,一些专家表示担心,人类的历史也会随着此类的超强大AI的诞生戛然而止,除非我们学会在AI成为超级智能之前即可使其与我们同心所向。

02

人工智能制造危险?

大多数研究人员都认为,超级智能人工智能不太可能表现出爱或恨等人类情感,也没有理由期望人工智能变得故意仁慈或恶意。 相反,在考虑人工智能如何成为风险时,专家认为最有可能有两种情况:

人工智能被编程为做一些毁灭性的事情:自主武器(autonomous weapon)是为杀戮而生的人工智能系统。若落入恶人手中,这些武器很容易便可造成大量伤亡。此外,AI军备竞赛也可能无意中引发AI战争,导致大量伤亡。为了避免被敌对势力从中阻挠,这些武器的“关闭”程式将被设计得极为复杂,因而人们也可能对这种情况失去掌控。这种风险虽然也存在于专用人工智能 (narrow AI)中,但随着AI智能和自驱动水平的提高,风险也会跟着增长。

人工智能被编程为做一些有益的事情,但它开发了一种破坏性的方法来实现其目标:这可能发生在我们尚未达到人类和人工智能目标的一致性(fully align),而解决人类和人工智能目标一致性的问题并不是一件容易的事。试想,如果你召唤一辆智能车将你以最快速度送到机场,它可能不顾一切地严格遵从你的指令,即使以你并不希望的方式——你可能因超速而被直升机追逐或呕吐不止。如果一个超智能系统的任务是一个雄心勃勃的地球工程项目,副效果可能是生态系统的破坏,并把人类试图阻止它的行为视为一个必须解除的威胁。

正如这些例子所表明的那样,对先进人工智能的担忧不是恶意,而是能力。 超级智能人工智能将非常擅长实现其目标,如果这些目标与我们的目标不一致,我们就会遇到问题。

比如,可能并非对蚂蚁深恶痛绝,也没有踩死蚂蚁的恶意,但如果负责水电绿色能源项目,而项目开发的所在地区有一个蚁丘会因为大水而被淹没,那只能说是算蚂蚁倒霉罢了。

人工智能安全研究的一个关键目的就是要避免将人类置于和这些蚂蚁同样的位置。

03

AI安全问题引发争议

埃隆·马斯克(Elon Musk)、史蒂夫·沃兹尼亚克(Steve Wozniak)和许多其他科技界的知名人士最近在媒体上和公开信中表达了对人工智能带来的风险的担忧,许多领先的人工智能研究人员也加入了进来。

为什么这个话题突然出现在头条新闻中?

长期以来,对强大人工智能的追求最终会成功的想法一直被认为是几个世纪或更长时间后的科幻小说。然而,由于最近的突破,许多人工智能里程碑,专家们认为几十年后才能实现的目标,现在已经达到了,这使得许多专家认真对待超级智能在我们有生之年就会出现的可能性。

虽然一些专家仍然猜测人类水平的人工智能还需要几个世纪的时间,但2015年波多黎各会议上的大多数人工智能研究都猜测它会在2060年之前发生。

因为人工智能有可能变得比任何人都更聪明,我们没有万无一失的方法来预测它的行为方式。我们不能把过去的技术发展作为基础,因为我们从来没有创造出任何有能力有意或无意地超越我们的东西。

事实上,我们能作为参考的依据便是人类本身的进化史。

人类之所以能在今天成为这个星球的万物之灵,并不是因为我们最强、最快或体积最大,而是因为我们是最具智慧的。如果有一天,我们不再是世上最聪明的,我们还能够自信对世界拥有控制力吗?

赢得这场竞赛的最佳方式不是阻碍前者,而是通过支持人工智能安全研究来加速后者。

一个常见的误区与AI的时间表有关:那就是人们认为他们能肯定地断定机器极大地取代人类智能到底需要多长的时间。

许多人误认为我们肯定能在这个世纪内制造出超越人类的人工智能。事实上,历史充满了人类将技术夸大的例子。

还有一种对AI最为极端的预测是,超越人类的人工智能永远不会诞生,因为它在物理上是不可能实现的。

然而,物理学家们都知道,大脑本身是由夸克和电子排列起来的强大计算机,而世上并没有物理学的规律规定人类不可能建立更加智能的夸克斑点。

目前,已经有一些调查问卷向AI研究人员询问,他们认为从现在起多少年后,我们将以至少50%的概率拥有人类水平的人工智能。所有的调查都有相同的结论, 那就是连世界上领先的专家都无法达到共识,所以说我们就更不能知道到底什么时候才会出现超越人类的人工智能。

在2015年波多黎各AI会议的AI调查中,平均(中值)答案是在2045年,但当中也有些研究人员猜测超越人类的人工智能只可能在数百年或更长的时间后发生。

还有一个相关的传言就是对AI有所担忧的人认为类人AI在几年内就会发生。事实上,大多数担心超越人类的人工智能会带来隐忧的人,但凡在记录上曾发言过的,都预测超越人类的人工智能至少需要几十年才会发生。

但他们认为,只要我们不是100%确定超越人类的人工智能不会在本世纪中发生,最聪明的做法就是现在便开始进行安全研究,以防范于未来。

许多与人类智能级别的人工智能相关的安全问题非常艰难,可能需要几十年才能解决。所以,与其等到一群过度操劳的程序员不小心启动问题前才做出对策,现在就开始针对这些安全问题进行研究是明智的。

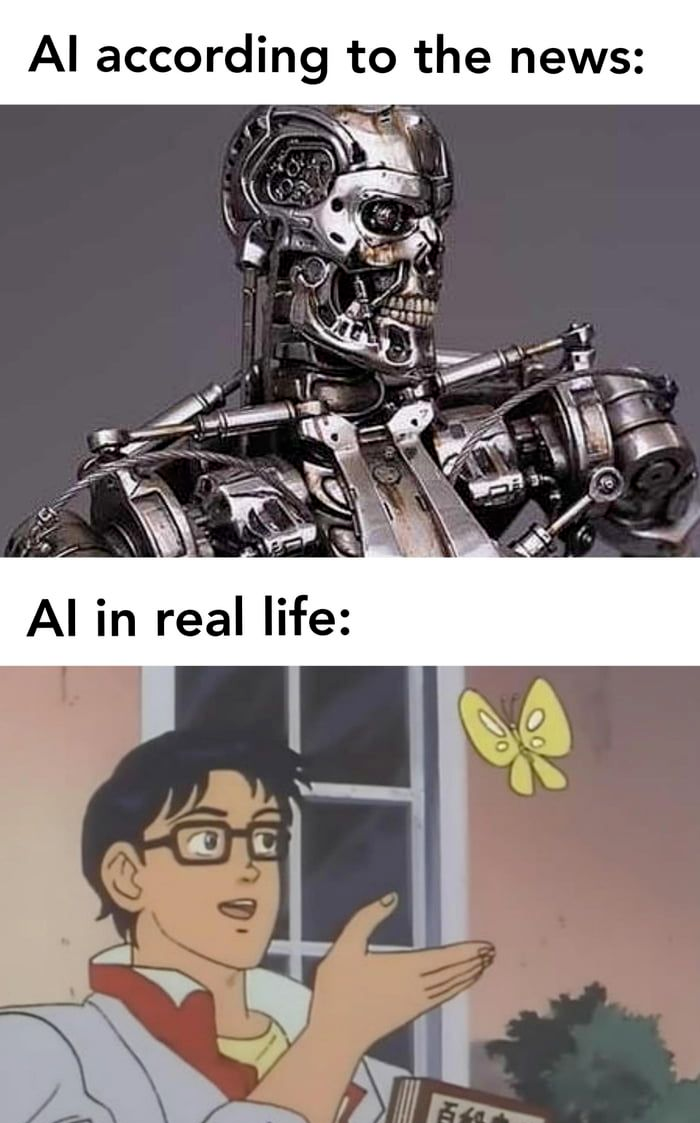

或许是媒体的夸大使人工智能的安全课题看起来比实际上更具争议。毕竟,在文章中使用恐吓的语言,并利用超出语境的引言来宣扬即将来临的危机可以比发表具平衡的报告引来更多的点击率。因此,若人们只是由媒体报道来了解彼此的立场, 他们可能会认为他们在立场上的分裂比事实上还要严重。

比如说,一个对科技存在怀疑的读者只读了比尔·盖茨在英国小报中所叙述的立场,便可能会错误地认为盖茨觉得超级智能即将来临。

同样的,参与符合共同利益的人工智能运动的人或许在并不理解吴恩达博士的确实立场前,就因为他对火星人口过多的发言而错误地认为他不在乎人工智能的安全。

然而事实上,他对人工智能安全具有一定的关心。他的发言的关键是因为吴恩达对时间线的估计更长,因此他自然地倾向于优先考虑短期内AI所能带来的挑战,多于考虑长期中可出现的挑战。

04

结语

如果你沿着道路行驶,你具有对颜色、声音等的主观体验。但是自动驾驶汽车会有主观体验吗?一部自动驾驶汽车,它需要对任何东西有所感受吗?虽然这种意识的奥秘本身是有趣的,但它与AI的风险无关。

如果你被无人驾驶的车撞到,它是否拥有主观感觉对你一点都不重要。相同的,会影响我们的是超智能AI所做的事,而不是它的主观感觉。

人类真正该担心的不是AI的恶意,而是能力。根据定义,超级人工智能非常善于实现其目标,无论这些目标是什么,所以我们需要确保其目标与我们的目标一致。

智慧产生控制力:人类之所以能够控制老虎不是因为我们更强壮,而是因为我们更聪明。

这也就意味着,如果我们放弃在地球上最聪明的地位,那我们也可能失去控制权。